はじめに

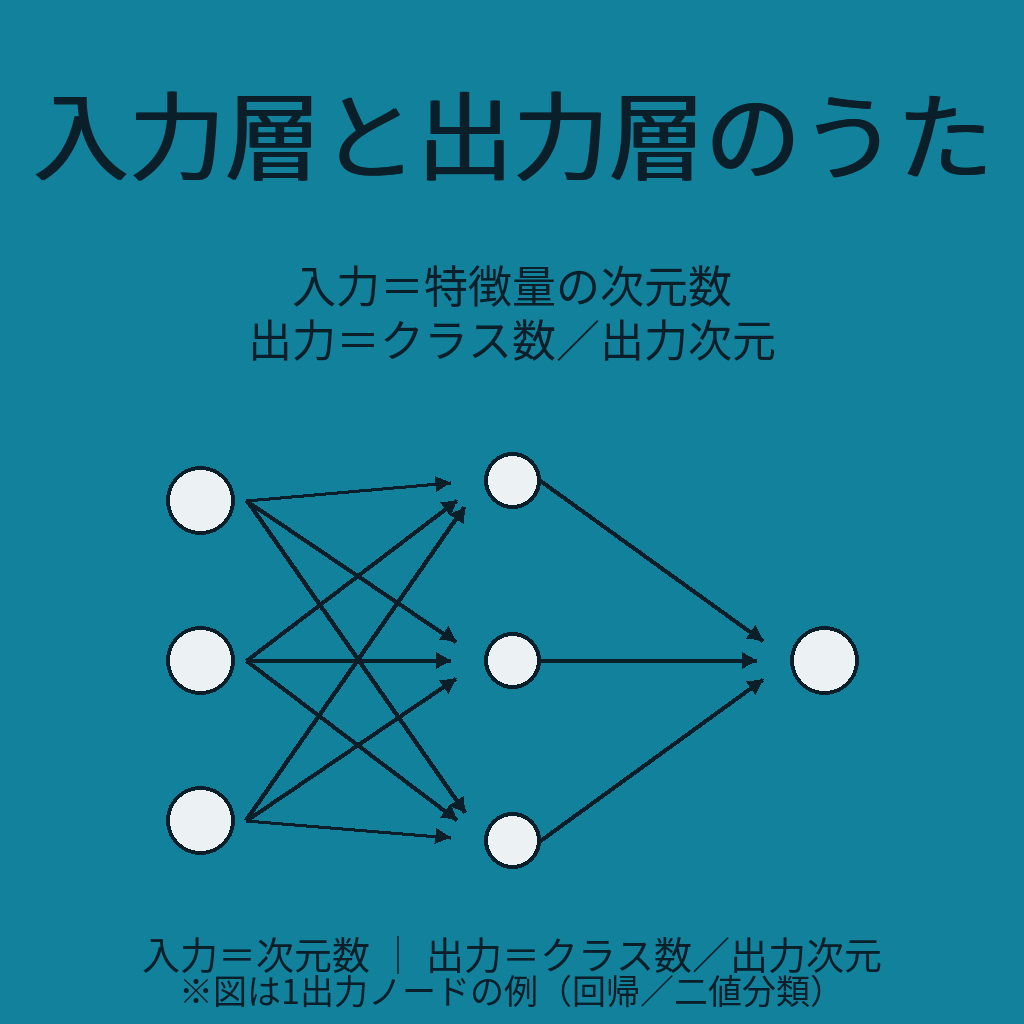

G検定では、ディープラーニングの基礎である入力層・出力層の役割や定義が頻出です。

特に「入力層のニューロン数=特徴量の次元数」「出力層の活性化関数と損失関数の対応」など、選択肢問題で混乱しやすいポイントが問われます。

この記事では、AIを活用して作成した楽曲「入力層と出力層覚えうた」を通して、試験に出る用語をリズムで記憶しやすくまとめます。

AIを活用した楽曲制作

今回の楽曲は、生成AIであるChatGPTを用いて歌詞を作成し、AI作曲ツールであるSuno AIを用いて音楽を生成しました。

スタイルは Up-tempo Educational Pops とし、短時間で耳に残りやすく、学習の定着に役立つよう工夫しています。

タイトル・歌詞の紹介

曲のタイトル

入力層と出力層覚えうた

歌詞

入力層は前処理後の観測データを受け取る 入力は特徴量として扱う

入力層のニューロン数は特徴量の次元数 入力層は重みを持たず、次の層が重みを持つ

前処理済みの数値ベクトルを入れる 正規化・標準化・One-Hotを施す

前処理は入力層の役割ではない 入力準備工程に含まれる

出力層は最終予測を出す層 分類ならクラス確率・ラベルを出力

回帰なら数値を直接出力 二値分類はシグモイド、多クラスはソフトマックス

回帰は活性化なしの恒等関数 出力層は損失関数と直接結びつく

出力の形式に合わせて損失を選ぶ 入力層と出力層の間は表現学習

中間層で入力を変換し特徴を作る 分類の出力ニューロン数はクラスの数

回帰の出力ニューロン数は出力ベクトルの次元数

確率を出すときはソフトマックス+交差エントロピー

楽曲の視聴

- YouTube

- Suno AI

入力層と出力層覚えうた(Suno AI)

歌詞の解説

入力層

「入力層は前処理後の観測データを受け取る」

入力層は観測データそのものではなく、正規化・標準化・ワンホット(One-Hot) など前処理を行った数値ベクトルを受け取ります。

入力層のニューロン数は、データの特徴量の次元数に等しくなります。

例:28×28のグレースケール画像 → 784次元(0〜255を0〜1に正規化)として数値ベクトル化。入力層ニューロン数=784。

「入力層は重みを持たず、次の層が重みを持つ」

入力層はただデータを渡すだけで、学習の対象となるパラメータは持ちません。

※一般的な全結合/CNNの入力層は重みを持たないが、単語埋め込みなど特殊な「入力用の変換層」は別途パラメータを持つ場合があります。

前処理

「前処理は入力層の役割ではない」

試験で混乱しやすい点です。前処理はモデルの外側で行われ、入力層自体が正規化やワンホット化を行うわけではありません。

出力層

「出力層は最終予測を出す層」

タスクに応じて出力層の設計は変わります。

- 二値分類

活性化関数にシグモイドを使い、出力は0〜1の確率。

損失関数は二値交差エントロピー(Binary Cross Entropy, BCE)。

- 多クラス分類

活性化関数にソフトマックスを使い、各クラスの確率を出力。

損失関数は多クラス交差エントロピー。

- 回帰

活性化関数を使わず恒等関数とし、実数値をそのまま出力。

分類ではクラス確率を出力し、ラベルはargmax(または閾値)で決定します。

出力層の活性化は損失関数の設計とセットで選びます。

中間層(隠れ層)

「入力層と出力層の間は表現学習」

中間層は入力を抽象化し、出力に適した特徴を生成する役割を担います。

これにより、入力から出力に至る複雑な変換が可能になります。

ニューロン数の関係

「分類の出力ニューロン数はクラスの数」

例えば3クラス分類なら出力ニューロンは3。

「回帰の出力ニューロン数は出力ベクトルの次元数」

例えば座標予測(x,y)の場合、出力は2次元となります。

楽曲に込めたメッセージ

G検定で出題される入力層・出力層の定義や役割を、音楽を通して自然に記憶できるように工夫しました。

特に 「入力=特徴量の次元数」「出力=クラス数/回帰の次元数」「活性化関数と損失関数の対応」 は間違えやすいため、歌詞で繰り返し強調しています。

まとめ

- 入力層は前処理済みの特徴量をそのまま受け取る。

- 入力層のニューロン数=特徴量の次元数。

- 出力層はタスクに応じて形を変える。

- 二値分類はシグモイド+二値交差エントロピー(BCE)、多クラス分類はソフトマックス+多クラス交差エントロピー、回帰は恒等関数。

- 出力層の活性化は損失関数の設計とセットで選ぶ。

試験に出る要点を歌にして覚えることで、リズムに乗せて知識を定着させることができます。

コメント