はじめに

G検定の勉強をしていて、最も混同しやすいのが自然言語処理(NLP)の分野ではないでしょうか。

「TransformerはRNNと何が違う?」「BERTはEncoder?それともDecoder?」「双方向なのはどっち?」

このようなモデルの構造や定義の違いは試験で頻出ですが、文字だけで覚えようとするとすぐに頭から抜けてしまいます。

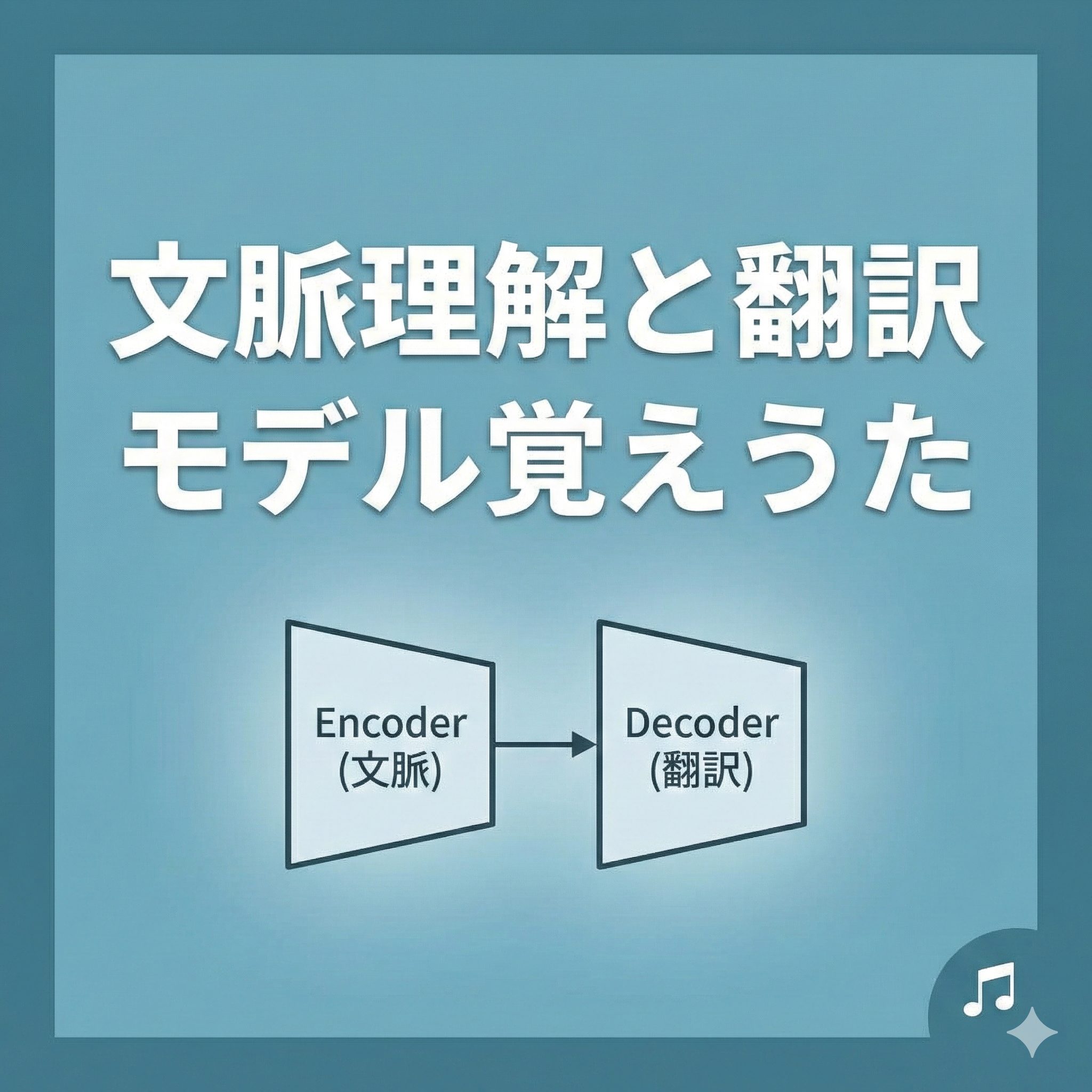

そこで今回は、試験直前でも記憶に残るよう、生成AIを使って「文脈理解と翻訳モデル覚えうた」を作成しました。

複雑な理論を、試験に出る「定義」と「キーワード」だけに絞って歌詞にしています。

この曲を聴いて、リズムで重要単語をマスターしましょう。

AIを活用した楽曲制作

今回の楽曲制作には、生成AIをフル活用しています。

歌詞の作成にはGoogleの「Gemini」を使用し、G検定の試験範囲に基づいた正確な定義を抽出しました。

そして、作曲にはAI音楽生成ツール「Suno AI」を使用しています。

疾走感のある覚えやすい曲に仕上げました。

タイトル・歌詞の紹介

曲のタイトル

文脈理解と翻訳モデル覚えうた

歌詞

TransformerはAttentionのみ RNN不要で並列計算

BERTはEncoder 双方向 GPTはDecoder 単方向

Seq2SeqはEncoderで 固定長の文脈ベクトルに圧縮

固定長が情報のボトルネック 長い文で精度が落ちる

Attentionは重みを動的計算 固定長ベクトルの制約を解消

ELMoはBi-LSTM 文脈依存でベクトルが変化する

TransformerはAttention Is All You Need

RNN使わずAttentionのみ 並列計算は前の時刻を待たない

学習が高速 Transformerの利点

Positional Encodingは 単語の位置情報を認識するため加算

BERTはTransformerのEncoder 文脈全体 双方向から同時に学習

MLMは穴埋め予測 NSPは連続判定 Fine-tuningでパラメータ全体を微調整

GPTはTransformerのDecoder 自己回帰的な単方向 文章生成が得意

BERTはEncoder 双方向 GPTはDecoder 単方向 Transformerは並列計算(×2)

楽曲の視聴

作成した楽曲は以下から試聴できます。

試験勉強の合間や移動中にぜひ聴いてみてください。

youtube

Suno AI

文脈理解と翻訳モデル覚えうた(Suno AI)

歌詞の解説

ここでは、歌詞に出てくる重要なキーワードについて、試験で問われるポイントを解説します。

数式は使わず、イメージで理解しましょう。

1. TransformerとRNNの違い

歌詞:Transformerは Attentionのみ / RNN不要で 並列計算 / 並列計算は 前の 時刻を 待たない

【ここがポイント】

従来のRNN(リカレントニューラルネットワーク)は、「前の単語の計算が終わらないと、次の単語の計算ができない(逐次計算)」という弱点がありました。

リレー形式のようにバトンを渡すのを待つ必要があるため、学習に時間がかかります。

一方、TransformerはRNNを使わず、文中の全単語を一度にまとめて(並列に)処理します。

これにより、学習時間が劇的に短縮されました。

「RNNは順番待ち、Transformerは一斉処理」と覚えましょう。

2. Seq2SeqとAttention

歌詞:固定長が 情報のボトルネック / Attentionは 重みを 動的計算

【ここがポイント】

Seq2Seq(Encoder-Decoder)は、Encoderが入力文の意味を「固定長のベクトル(数値の列)」にギュッと圧縮します。

しかし、長い文章を無理やり固定サイズに詰め込むと、情報が入りきらずに翻訳精度が落ちてしまいます。

これを「情報のボトルネック」と呼びます。

Attention(注意機構)は、この問題を解決するために、「翻訳するときに、元の文のどの単語に注目(Attention)すべきか」をその都度計算する仕組みです。

これにより、長い文章でも正確に翻訳できるようになりました。

3. ELMoと文脈依存

歌詞:ELMoは Bi-LSTM / 文脈依存で ベクトルが 変化する

【ここがポイント】

Word2Vecなどの古い手法では、「Bank」という単語は常に同じベクトル(数値)でした。

しかし、ELMoは双方向LSTM(Bi-LSTM)を使うことで、文脈を読み取ります。

「川のBank(土手)」と「お金のBank(銀行)」で、同じ単語でも異なるベクトル値を持つことができるのが最大の特徴です。

これを「文脈依存」と呼びます。

4. Positional Encoding

歌詞:Positional Encodingは / 単語の 位置情報を 認識するため 加算

【ここがポイント】

TransformerはRNNのように「前から順に」処理をしないため、そのままだと「私が猫を」と「猫が私を」という語順(位置情報)の違いを理解できません。

そのため、単語のデータにあらかじめ「これは1番目、これは2番目」という位置情報を表す値(サイン波などを利用)を足し合わせます。

これをPositional Encodingと言います。

5. BERT (Encoder/双方向/MLM)

歌詞:BERTは Transformerの Encoder / 文脈全体 双方向から 同時に 学習

【ここがポイント】

BERTは、TransformerのEncoder(入力理解パート)のみを重ねたモデルです。

文章の「理解」に特化しているため、文の最初と最後、両方から文脈を見る「双方向」の学習を行います。

代表的な事前学習タスクは以下の2つです。

- MLM (Masked Language Model)

文中の単語を[MASK]で隠し、前後の文脈からその単語を穴埋めするタスク。 - NSP (Next Sentence Prediction)

2つの文がつながっているかを当てるタスク。

6. GPT (Decoder/単方向)

歌詞:GPTは Transformerの Decoder / 自己回帰的な 単方向 文章生成が 得意

【ここがポイント】

GPTは、TransformerのDecoder(出力生成パート)のみを使ったモデルです。

文章の「生成」に特化しています。

「昔々、あるところに」と入力されたら、その次に来る単語を予測して出力します。

後ろの単語をカンニングしてはいけないため、前から順に学習する「単方向(自己回帰)」モデルとなります。

★最後のまとめ(試験対策)

- BERT = Encoder = 双方向 = 穴埋め(理解が得意)

- GPT = Decoder = 単方向 = 次単語予測(生成が得意)

この対比は試験で絶対に出るので、歌詞のサビでしっかり覚えましょう。

楽曲に込めたメッセージ

G検定の範囲は広く、特に深層学習のモデル構造は似たような用語が多くて混乱しがちです。

しかし、それぞれのモデルが「何を解決するために生まれたのか(例:RNNの遅さを解決したTransformer)」、「どの部分を使っているのか(EncoderかDecoderか)」というポイントさえ押さえれば、正答率はぐっと上がります。

この曲は、余計な比喩を排除し、試験に出る「定義」そのものを歌詞にしました。

口ずさむだけで、自然と試験に必要な知識が定着することを目指しています。

まとめ

今回は、AIを活用してG検定対策ソングを作ってみました。

「BERTはEncoderで双方向」、「GPTはDecoderで単方向」。

この違いだけでも覚えておくと、試験で迷うことが少なくなります。

ぜひこの曲を活用して、G検定合格を目指してください。

コメント