はじめに

G検定の学習では、多くの専門用語や定義を正確に理解する必要があります。

特に「隠れ層」や「活性化関数」など、ニューラルネットワークの基礎を理解していないと試験問題で間違いやすいポイントとなります。

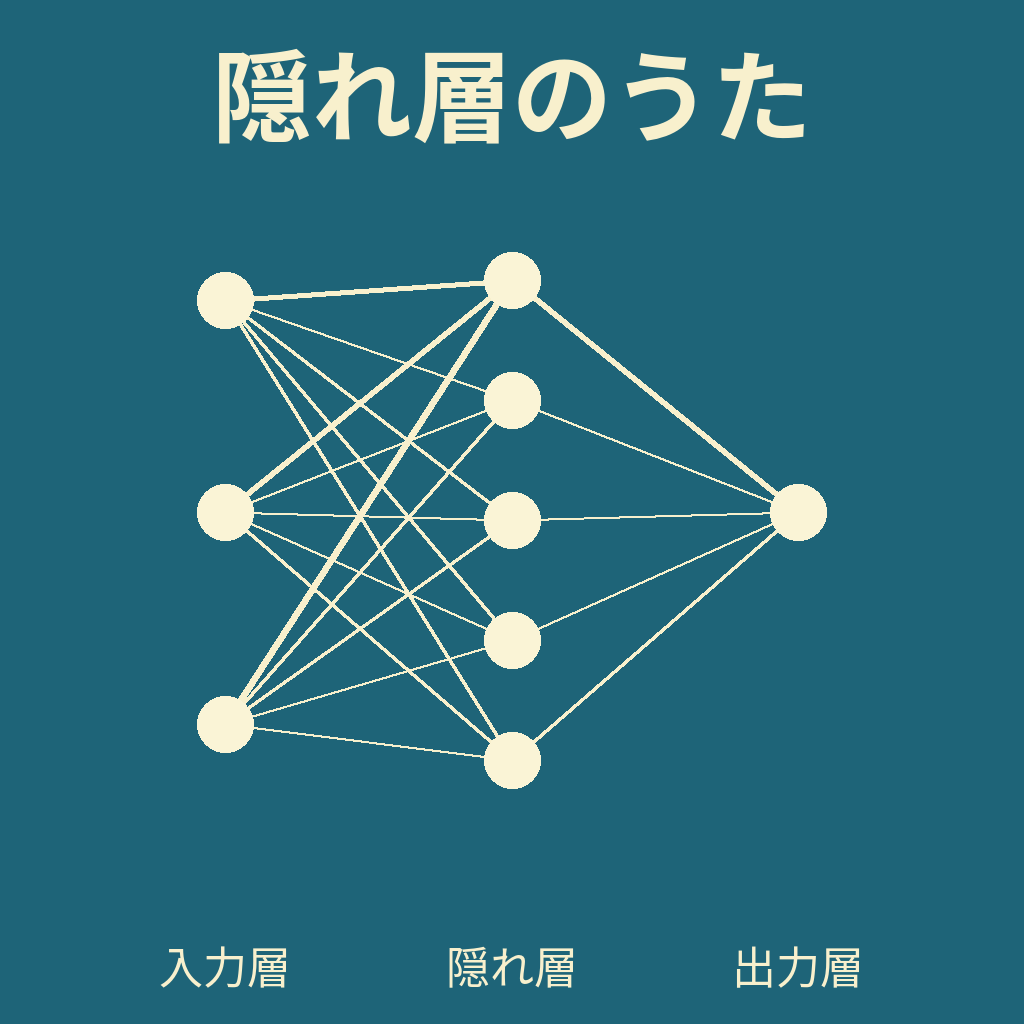

本記事では、AIを活用して制作した教育ソング「隠れ層のうた」を通じて、用語の意味を音楽のリズムに合わせて効率よく覚える方法をご紹介します。

AIを活用した楽曲制作

今回の楽曲は、生成AI(ChatGPT)で歌詞を作成し、AI作曲ツール(Suno AI)で音楽を制作しました。

スタイルは教育向けエレクトロポップで、学習中でもテンポよくリズムに乗って記憶できるように工夫しています。

タイトル・歌詞の紹介

曲のタイトル

隠れ層のうた

歌詞

隠れ層は入力層と出力層の間にある中間の層

外部から直接観測できない内部表現を保持する層

隠れ層の目的は特徴変換・抽出 隠れ層の価値は非線形性の導入

活性化関数は非線形性を与える装置

活性化関数が線形なら深さの効果は消える

同じパラメータ数でも 深いネットワークは階層的表現を学び

複雑な関数を表現しやすい 非線形がないならばその深さは無意味

単層パーセプトロンは線形分離のみ

多層は非線形活性化で非線形問題を解決できる

隠れ層の数を増やしても 性能向上とは限らない

隠れ層は特徴変換・抽出、非線形の導入を担当

過学習や勾配消失の懸念があるため 適切な設計と正則化が必要

楽曲の視聴

- YouTube

- Suno AI

隠れ層のうた(Suno AI)

歌詞の解説

隠れ層は入力層と出力層の間にある中間の層

隠れ層はニューラルネットワークの内部に存在し、直接外部からは観測できません。

入力を受け取り、内部表現へと変換し、出力層につなぎます。

活性化関数は非線形性を与える装置

活性化関数はネットワークに非線形性を与えます。

すべての層が線形(アフィン)であれば、合成しても全体は線形のままです。

そのため、活性化関数が線形だと、層を深くしても表現力は増えません。

代表例:ReLU(0未満は0、0以上は入力をそのまま出力)、Sigmoid(出力範囲0~1)、tanh(出力範囲-1~1)。

\(\sigma(x)=\frac{1}{1+e^{-x}}\)(Sigmoidの例)。

同じパラメータ数でも深いネットワークは階層的表現を学び

層が深いと、低次の特徴(エッジなど)から高次の特徴(部品や全体像)へと階層的に学習できます。

同じパラメータ数でも、適切な初期化・正則化・最適化がある場合は、深いネットワークのほうが複雑な関数を効率よく表現しやすいことがあります。

単層パーセプトロンは線形分離のみ

単層パーセプトロンはデータを平面(2次元なら直線)で分けられる場合にのみ正しく分類できます(線形分離)。

多層では非線形活性化を用いることで、曲線や折れ線による複雑な境界も表現できるようになります。

隠れ層の数を増やしても性能向上とは限らない

層を増やすと、学習データには合っていても未知データで悪化する過学習や、誤差が深部に届きにくい勾配消失が生じやすくなります。

対策として、Weight Decay(L2正則化)、Dropout、適切な活性化(ReLU系)、初期化(Xavier/He)、正規化(BatchNorm)などを併用します。

楽曲に込めたメッセージ

この曲には「試験で間違えやすい定義をリズムで自然に覚える」という意図があります。

音楽と一緒に繰り返し聴くことで、記憶の定着をサポートします。

まとめ

「隠れ層のうた」は、G検定で間違えやすい隠れ層や活性化関数のポイントを音楽で覚えるために制作しました。

AIによる作詞・作曲の組み合わせで、学習をより楽しく効率的に進められます。

受験勉強の合間にぜひ視聴してみてください。

コメント